本記事3行要約:

● 論文投稿数 4,407件、採択件数 941件、採択率 21.3%!

● 機械学習の応用で最も人気がある領域の一つで「言語モデル」が圧倒的トレンド!

● 日本人著者を含む論文は20件(採択総数941件)で全体の2.1%!

自然言語処理分野は、ChatGPTをはじめとして、近年脚光を浴びる生成AIの震源地とも言える分野です。この領域における最高峰のカンファレンスとして、ACL(Annual Meeting of the Association for Computational Linguistics)があります。これまでResearchPortでは、言語分野は取り上げられていなかったため、2024年8月に開催されたACL2024を概観しながら、マクロな特徴を説明していきます。

ACL2024 開催概要

▶ 開催期間: 11 – 16 Aug., 2024

▶ 開催都市: Bangkok, Thailand

▶ 公式HP: https://2024.aclweb.org/

■ACLとは

まずACLとは、Association for Computational Linguistics(計算言語学会)が毎年開催している例会であり、自然言語処理分野では、EMNLP(Empirical Methods in Natural Language Processing)、NAACL(North American Chapter of the Association for Computational Linguistics)とともに最高峰の一つと言われています。これについてはカンファレンスランクでまとめておりますので、そちらもご参照ください。

ACLの歴史は古く、1962年に前身となるAMTCL(Association for Machine Translation and Computational Linguistics)が結成され、さらに初回の年次大会が1964年にACM(Association for Computing Machinery)のNational Conferenceと併催の形で開催されました。それ以降、少しずつ現代的な内容に整備され、1979年以降は現代のような論文集が発行されるに至っています。

これらについては全て電子化されており、こちら(https://aclanthology.org/)で読むことができます。

この会議の査読システムにも特徴があります。

近年、AI分野全体に対する注目が集まる中で、ChatGPTなど革新技術を生み出す震源地となった自然言語処理分野の過熱ぶりも高く、結果的に他のAI分野の例に漏れず、論文投稿数も増加の一途です。そのような中で、査読システムおよびその効率を改善すべく、ACLでは[ACL Rolling Review(以降、ARR)]というシステムを運用しています。この特異なシステムについては、こちらに初期の提案が記載されていますが、上記に示した最高峰会議間で査読者プールを共有し、隔月の投稿機会において計画的に投稿ができます。これにより、査読プロセスはより統一的になり運用的にもシステマティックになるとともに、最高峰会議の間で査読基準が均一化されるというものです。一方で、一度査読が通らなかった場合には、同基準であるため、ある程度修正しない限り同じ内容では別会議に通すことは難しくなるかも知れず、上記のARRの提案書で示されているように投稿内容に多様性の面での懸念はあります。

いずれにしても、このシステムは他分野にも波及する可能性が高い査読システムかもしれません。このあたりの制度は頻繁に更新されており、今後も落ち着くまでに議論を経て改良が続けられるかもしれませんが、新たなプロセスやコミュニティの改善活動も積極的に行いつつ、AI業界・コンピュータサイエンス業界をリードしているのが、ACLといっても過言ではありません。

論文のカテゴリについても様々な改良が加えられてきました。

当初より[Long paper]および[Short paper]というカテゴリがあったのですが、2021以降は[Findings]と呼ばれるカテゴリが新設されました。Findingsとは、Long paperやShort paperでは採択されなかったが、一定の価値を持つと判断された論文のカテゴリです。

ACL2024では、Long+Shortで約21%の採択率、Findingsは22%の採択率となっています。そのため、これら全てを含めると投稿論文全体の43%が採択率ということになりますが、下に示す過去の流れと一貫性を保つためにはACL2021以降はLong+Shortを本会議の採択率と考えるのが良いように思います。

他分野のトップティア会議も、本会議で扱われる論文の採択率は20-25%となっているので、それらと同等の難易度ということで考えても、Long+Shortまでの狭義でACL採択率と考えるのが妥当と思われます。

■ACL2024総括

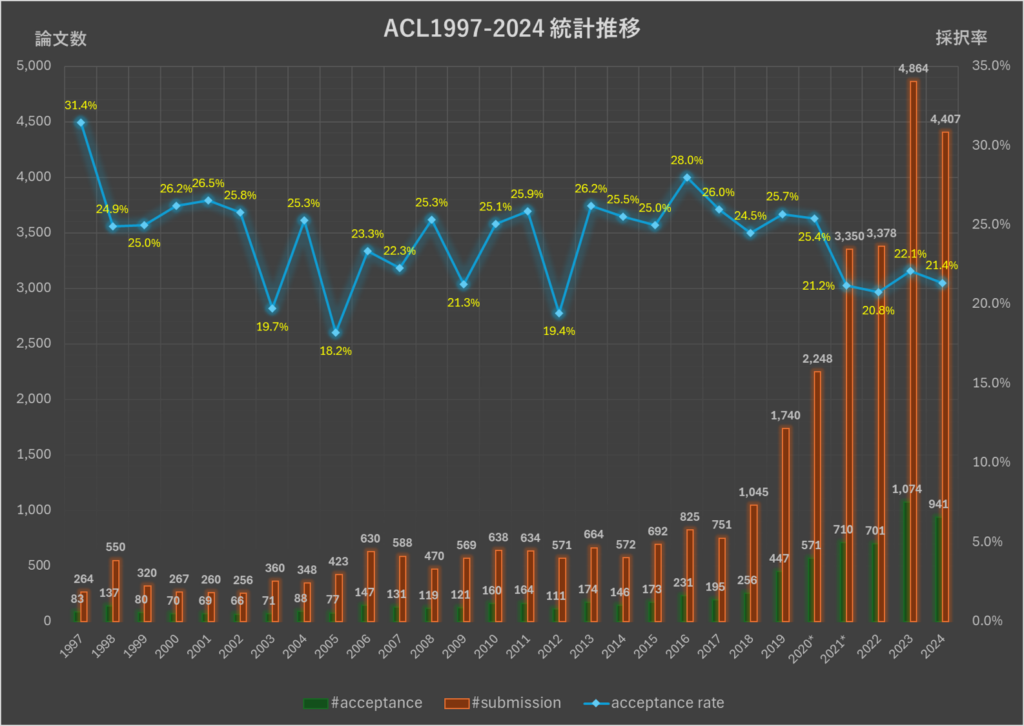

前置きが長くなりましが、投稿数や採択率の推移を見てまいります(表1・図1)。

他分野と同様に、論文投稿数は増加傾向ですが、採択率は一貫して18-25%を維持しています。ここに採択数の内訳は、様々な改革や取り組みが行われているため、必ずしも同じ意味ではありませんが、本会議で発表された論文を全てカウントしたものになります。

| Year | # submission | acceptance | acceptance rate | Venue |

|---|---|---|---|---|

| 1997 | 264 | 83 | 31.4% | Madrid, Spain |

| 1998 | 550 | 137 | 24.9% | Montreal, Quebec, Canada |

| 1999 | 320 | 80 | 25.0% | College Park, Maryland, USA |

| 2000 | 267 | 70 | 26.2% | Hong Kong, China |

| 2001 | 260 | 69 | 26.5% | Toulouse, France |

| 2002 | 256 | 66 | 25.8% | Philadelphia, PA, USA |

| 2003 | 360 | 71 | 19.7% | Sapporo, Japan |

| 2004 | 348 | 88 | 25.3% | Barcelona, Spain |

| 2005 | 423 | 77 | 18.2% | University of Michigan, USA |

| 2006 | 630 | 147 | 23.3% | Sydney, NSW, Australia |

| 2007 | 588 | 131 | 22.3% | Prague, Czech Republic |

| 2008 | 470 | 119 | 25.3% | Columbus, Ohio, USA |

| 2009 | 569 | 121 | 21.3% | Singapore |

| 2010 | 638 | 160 | 25.1% | Uppsala, Sweden |

| 2011 | 634 | 164 | 25.9% | Portland, Oregon, USA |

| 2012 | 571 | 111 | 19.4% | Jeju Island, Korea |

| 2013 | 664 | 174 | 26.2% | Sofia, Bulgaria |

| 2014 | 572 | 146 | 25.5% | Baltimore, MD, USA |

| 2015 | 692 | 173 | 25.0% | Beijing, China |

| 2016 | 825 | 231 | 28.0% | Berlin, Germany |

| 2017 | 751 | 195 | 26.0% | Vancouver, Canada |

| 2018 | 1,045 | 256 | 24.5% | Melbourne, Australia |

| 2019 | 1,740 | 447 | 25.7% | Florence, Italy |

| 2020 | 2,248 | 571 | 25.4% | Online |

| 2021 | 3,350 | 710 | 21.2% | Online |

| 2022 | 3,378 | 701 | 20.8% | Dublin, Ireland |

| 2023 | 4,864 | 1,074 | 22.1% | Toronto, Canada |

| 2024 | 4,407 | 941 | 21.4% | Bangkok, Thailand |

表1 ACL論文投稿数および採択率

*年によって計上方法に多少の差が発生している。

2021~: ■submission(long+short+findings) ■aceeptance(long+short) ■acceptance rate(long+short)

~2020: ■submission(long) ■aceeptance(long) ■acceptance rate(long)

*これ以降の統計では公式数値と若干の誤差がある。

上記統計は学会開催前に準備されたものであるが、論文集を解析した結果は、実際に発表されたり、当日No Showであったものが採録に至らなかったりと、多少の増減が発生するため完全一致しない。

■日本人研究者別-論文採択数

本カンファレンスでも、日本人著者の活躍も調べておりますので、下記に示します。

まずは早速、ACL2024での日本からの投稿と個人別採択件数ランキングをご覧ください(表2・図2)。

| 採択数 | 日本人著者 を含む論文 |

日本人著者が 絡む論文比率 |

全著者数 | 日本人 著者数 |

日本人 著者比率 |

|

|---|---|---|---|---|---|---|

| ACL2024[long] | 864 | 16 | 1.9% | 5,206 | 30 | 0.6% |

| ACL2024[short] | 77 | 4 | 5.2% | 352 | 9 | 2.6% |

| ACL2024[long+short] | 941 | 20 | 2.1% | 5,558 | 39 | 0.7% |

| ACL2024[findings] | 975 | 38 | 3.9% | 5,455 | 94 | 1.7% |

表2 ACL投稿論文全体の著者数に占める日本人比率

著者別論文数

| 著者 | 採択数 |

|---|---|

| Kenji Kawaguchi |

2

|

| Shinji Watanabe |

2

|

| Fumiyo Fukumoto |

1

|

| Kazuki Hayashi |

1

|

| Katsuhiko Hayashi |

1

|

| Takayuki Hori |

1

|

| Go Inoue |

1

|

| Kentaro Inui |

1

|

| Masaru Isonuma |

1

|

| Yusuke Iwasawa |

1

|

| Hidetaka Kamigaito |

1

|

| Ryo Kamoi |

1

|

| Akihiko Kato |

1

|

| Tatsuki Kuribayashi |

1

|

| Masato Mita |

1

|

| Yuki Mitsufuji |

1

|

| Yusuke Miyao |

1

|

| Soichiro Murakami |

1

|

| Mutsumi Nakamura |

1

|

| Taichi Nakatani |

1

|

| Yohei Oseki |

1

|

| Yusuke Sakai |

1

|

| Hiromasa Sakurai |

1

|

| Haruki Sato |

1

|

| Yui Sudo |

1

|

| Yuma Suzuki |

1

|

| Yoshimi Suzuki |

1

|

| Chihiro Taguchi |

1

|

| Takumi Takada |

1

|

| Hiroki Takushima |

1

|

| Hayato Tanoue |

1

|

| Ryo Ueda |

1

|

| Kazuya Ueki |

1

|

| Masao Utiyama |

1

|

| Hiromi Wakaki |

1

|

| Taro Watanabe |

1

|

| Ryo Yoshida |

1

|

図2 ACL2024(Lomg+Short)著者別論文数

表2を見ると、Long+Short全体の論文のうち、2.1%が日本人と思われる著者が関係している論文であたことが分かります。一方で、著者の延べ人数に対して日本人著者の割合は0.7%ということで、論文数よりもはるかに少ない状況です。これは日本人の研究者で海外に出向いて共著は主に外国人チーム体制で執筆された論文も含んでいるため、そのような結果になっているのかもしれません。

尚、この数値は、CVPRなど他AI分野とも非常に近い数値となっております(参照:CVPR2024-速報-)。

参考までに、Findingsも含めた日本人著者別ランキングも出してみました(表3)。

| ACL2024 | |||||

|---|---|---|---|---|---|

| Long paper | Short paper | Finding paper | |||

| Name | #Papers | Name | #Papers | Name | #Papers |

| Shinji Watanabe | 2 | Yoshimi Suzuki | 1 | Taro Watanabe | 5 |

| Kenji Kawaguchi | 2 | Fumiyo Fukumoto | 1 | Hidetaka Kamigaito | 3 |

| Masato Mita | 1 | Yusuke Iwasawa | 1 | Hiromi Wakaki | 2 |

| Soichiro Murakami | 1 | Kentaro Inui | 1 | Sadao Kurohashi | 2 |

| Akihiko Kato | 1 | Kazuki Hayashi | 1 | Yohei Oseki | 2 |

| Hiromasa Sakurai | 1 | Yusuke Sakai | 1 | Yuu Jinnai | 2 |

| Yusuke Miyao | 1 | Hidetaka Kamigaito | 1 | Ryohei Sasano | 2 |

| Hiromi Wakaki | 1 | Katsuhiko Hayashi | 1 | Koichi Takeda | 2 |

| Yuki Mitsufuji | 1 | Taro Watanabe | 1 | Manabu Okumura | 2 |

| Masaru Isonuma | 1 | Yusuke Sakai | 2 | ||

| Masao Utiyama | 1 | Saku Sugawara | 2 | ||

| Takumi Takada | 1 | Norihito Naka | 1 | ||

| Yuma Suzuki | 1 | Kiyoshi Izumi | 1 | ||

| Hiroki Takushima | 1 | Hiroki Sakaji | 1 | ||

| Hayato Tanoue | 1 | Masanari Ohi | 1 | ||

| Haruki Sato | 1 | Masahiro Kaneko | 1 | ||

| Takayuki Hori | 1 | Ryuto Koike | 1 | ||

| Kazuya Ueki | 1 | Naoaki Okazaki | 1 | ||

| Yui Sudo | 1 | Yusuke Miyao | 1 | ||

| Mutsumi Nakamura | 1 | Akihiro Maeda | 1 | ||

| Taichi Nakatani | 1 | Takuma Torii | 1 | ||

| Tatsuki Kuribayashi | 1 | Shohei Hidaka | 1 | ||

| Ryo Ueda | 1 | Hiroshi Kanayama | 1 | ||

| Ryo Yoshida | 1 | Ran Iwamoto | 1 | ||

| Yohei Oseki | 1 | Junya Ono | 1 | ||

| Go Inoue | 1 | Naoki Murata | 1 | ||

| Chihiro Taguchi | 1 | Takashi Shibuya | 1 | ||

| Ryo Kamoi | 1 | Yuki Mitsufuji | 1 | ||

| Ryo Yoshida | 1 | ||||

| Taiga Someya | 1 | ||||

| Kenji Kawaguchi | 1 | ||||

| Gaku Morio | 1 | ||||

| Satoshi Nakamura | 1 | ||||

| Ikuya Yamada | 1 | ||||

| Ryokan Ri | 1 | ||||

| Hiroshi Arakawa | 1 | ||||

| Taichi Aida | 1 | ||||

| Tomoe Taniguchi | 1 | ||||

| Daichi Mochihashi | 1 | ||||

| Ichiro Kobayashi | 1 | ||||

| Fumika Isono | 1 | ||||

| Ukyo Honda | 1 | ||||

| Tetsuro Morimura | 1 | ||||

| Kaito Ariu | 1 | ||||

| Masashi Oshika | 1 | ||||

| Makoto Morishita | 1 | ||||

| Tsutomu Hirao | 1 | ||||

| Sakiko Yahata | 1 | ||||

| Teruhisa Misu | 1 | ||||

| Hiroyuki Deguchi | 1 | ||||

| Hideki Tanaka | 1 | ||||

| Masao Utiyama | 1 | ||||

| Shinji Watanabe | 1 | ||||

| Yoshinori Maeda | 1 | ||||

| Keiichi Yamada | 1 | ||||

| Ryoma Kumon | 1 | ||||

| Hitomi Yanaka | 1 | ||||

| Yukiya Hono | 1 | ||||

| Koh Mitsuda | 1 | ||||

| Kentaro Mitsui | 1 | ||||

| Toshiaki Wakatsuki | 1 | ||||

| Kei Sawada | 1 | ||||

| Akari Haga | 1 | ||||

| Akiyo Fukatsu | 1 | ||||

| Miyu Oba | 1 | ||||

| Hiroki Ouchi | 1 | ||||

| Hiroya Takamura | 1 | ||||

| Ryutaro Ichise | 1 | ||||

| Daiki Asami | 1 | ||||

| Shiki Sato | 1 | ||||

| Reina Akama | 1 | ||||

| Jun Suzuki | 1 | ||||

| Kentaro Inui | 1 | ||||

| Kentaro Ozeki | 1 | ||||

| Risako Ando | 1 | ||||

| Takanobu Morishita | 1 | ||||

| Hirohiko Abe | 1 | ||||

| Koji Mineshima | 1 | ||||

| Mitsuhiro Okada | 1 | ||||

表3 ACL2024各カテゴリにおける著者別ランキング

さらに、過去4年における論文数の著者別累計(Long+Short)も見てみましょう(図3)。

1本の著者まで含めると膨大になるため、2本以上の採択数でランキングを出しております。

著者別ランキング

| 著者 | 採択数 |

|---|---|

| Tatsunori Hashimoto |

5

|

| Shinji Watanabe |

5

|

| Hidetaka Kamigaito |

4

|

| Saku Sugawara |

4

|

| Taro Watanabe |

4

|

| Akari Asai |

3

|

| Yasuhisa Fujii |

3

|

| Kazuma Hashimoto |

3

|

| Katsuhiko Hayashi |

3

|

| Hirofumi Inaguma |

3

|

| Sadao Kurohashi |

3

|

| Naoaki Okazaki |

3

|

| Manabu Okumura |

3

|

| Yoshimasa Tsuruoka |

3

|

| Naoki Yoshinaga |

3

|

| Akiko Aizawa |

2

|

| Jun Araki |

2

|

| Yuki Arase |

2

|

| Kotaro Funakoshi |

2

|

| Kentaro Inui |

2

|

| Masahiro Kaneko |

2

|

| Kenji Kawaguchi |

2

|

| Daiki Kimura |

2

|

| Hideo Kobayashi |

2

|

| Tatsuki Kuribayashi |

2

|

| Yuki Mitsufuji |

2

|

| Yusuke Miyao |

2

|

| Yasumasa Onoe |

2

|

| Yohei Oseki |

2

|

| Ryokan Ri |

2

|

| Keisuke Sakaguchi |

2

|

| Ryohei Sasano |

2

|

| Ryuichi Takanobu |

2

|

| Koichi Takeda |

2

|

| Michiaki Tatsubori |

2

|

| Masao Utiyama |

2

|

| Hiromi Wakaki |

2

|

| Ikuya Yamada |

2

|

| Ryo Yoshida |

2

|

図3 ACL2021-2024(Long+Short)著者別ランキング

■トレンドキーワードの推移

ACLでも、タイトル内(Long+Short)のキーワード出現頻度についてまとめてみました(表4)。

2024年に関しては、圧倒的に言語モデル(language model)および、言語モデリングに相当するキーワード(LLMなど)が多く、この2つのキーワードだけで45%強も出現しておりました。

他分野含めても、ここまで一つのキーワードが多く取り上げられることはなく、単なるバズワードではなく、アカデミアにおいても非常に大きなインパクトを与えらていることを示しています。

また、ベンチマーク(benchmark)やさらに言語モデルに論理推論能力を持たせるための研究(Reasoning)も多くなってきていることが伺えます。さらに、検索拡張生成(Retrieval Augmented Generation:RAG)と関係するものと思われますが、検索(Retrieval)などもキーワードとして上位に浮上してきています。

| 2024 | 2023 | 2022 | 2021 | ||||

|---|---|---|---|---|---|---|---|

| language model | 32.41% | language model | 13.58% | language model | 10.00% | translation | 8.31% |

| llm | 13.28% | generation | 8.84% | generation | 9.00% | generation | 7.61% |

| generation | 6.91% | learning | 8.19% | translation | 7.29% | language model | 7.32% |

| benchmark | 6.38% | translation | 6.79% | learning | 7.00% | graph | 6.76% |

| reasoning | 6.27% | reasoning | 4.84% | graph | 5.00% | learning | 6.62% |

| learning | 6.06% | graph | 4.56% | pre training | 3.86% | detection | 4.79% |

| translation | 4.04% | dataset | 4.47% | transformer | 3.86% | transformer | 4.79% |

| retrieval | 3.93% | question answer | 3.63% | parsing | 3.86% | question answer | 4.51% |

| graph | 3.51% | training | 3.54% | representation | 3.71% | representation | 4.23% |

| dataset | 3.29% | detection | 3.44% | dataset | 3.57% | recognition | 3.80% |

| detection | 3.19% | retrieval | 2.98% | training | 3.29% | dataset | 3.66% |

| alignment | 3.19% | recognition | 2.98% | classification | 3.14% | embedding | 3.52% |

| training | 2.98% | zero shot | 2.79% | question answer | 3.00% | attention | 3.38% |

| question answer | 2.87% | benchmark | 2.70% | unsupervised | 2.86% | training | 3.24% |

| instruction | 2.87% | pre training | 2.61% | zero shot | 2.57% | classification | 2.96% |

| tuning | 2.23% | modeling | 2.61% | modeling | 2.57% | modeling | 2.82% |

| fine tuning | 2.23% | transformer | 2.51% | reasoning | 2.43% | reasoning | 2.82% |

| representation | 2.02% | classification | 2.42% | detection | 2.43% | unsupervised | 2.68% |

| transformer | 2.02% | representation | 2.33% | contrastive learning | 2.43% | parsing | 2.54% |

| zero shot | 1.91% | tuning | 2.23% | transfer | 2.43% | pre training | 2.39% |

| embedding | 1.81% | generalization | 2.23% | recognition | 2.43% | adversarial | 2.25% |

| long context | 1.59% | few shot | 2.23% | few shot | 2.43% | prediction | 2.11% |

| generative | 1.49% | unsupervised | 2.05% | embedding | 2.29% | label | 1.97% |

| attack | 1.38% | generative | 1.77% | benchmark | 2.14% | benchmark | 1.83% |

| editing | 1.28% | label | 1.77% | label | 2.14% | few shot | 1.83% |

| space | 1.28% | attention | 1.67% | tuning | 2.00% | retrieval | 1.69% |

| search | 1.17% | fine tuning | 1.67% | retrieval | 1.86% | verification | 1.41% |

| classification | 1.06% | prediction | 1.58% | attention | 1.71% | contrastive learning | 1.41% |

| reinforcement learning | 1.06% | adversarial | 1.49% | generalization | 1.57% | alignment | 1.41% |

| recognition | 1.06% | contrastive learning | 1.40% | prediction | 1.43% | zero shot | 1.41% |

| multi modal | 0.96% | alignment | 1.40% | alignment | 1.43% | fine tuning | 1.27% |

| expert | 0.96% | embedding | 1.30% | fine tuning | 1.43% | generative | 1.27% |

| pre training | 0.96% | transfer | 1.30% | generative | 1.29% | end to end | 1.13% |

| attention | 0.96% | parsing | 1.21% | reading | 1.29% | generalization | 1.13% |

| unsupervised | 0.85% | instruction | 1.21% | adversarial | 1.00% | search | 1.13% |

| distillation | 0.85% | multi modal | 1.12% | domain adaptation | 0.86% | interaction | 0.99% |

| answer | 0.85% | interaction | 1.12% | segmentation | 0.86% | attack | 0.99% |

| estimation | 0.85% | correction | 1.12% | disentangl | 0.86% | reading | 0.99% |

| prediction | 0.85% | knowledge distillation | 1.12% | meta learning | 0.86% | transfer | 0.85% |

| label | 0.85% | attack | 1.02% | answer | 0.86% | knowledge distillation | 0.85% |

| few shot | 0.74% | fusion | 1.02% | tracking | 0.71% | feature | 0.85% |

| spars | 0.74% | representation learning | 0.93% | distillation | 0.71% | variation | 0.85% |

| fusion | 0.64% | search | 0.93% | spars | 0.71% | video | 0.85% |

| generalization | 0.64% | cross modal | 0.93% | style transfer | 0.71% | correction | 0.85% |

| transfer | 0.64% | latent | 0.84% | self supervised | 0.71% | space | 0.70% |

| grounding | 0.64% | expert | 0.84% | multi task learning | 0.71% | captioning | 0.70% |

| adversarial | 0.64% | answer | 0.84% | latent | 0.71% | meta learning | 0.70% |

| modeling | 0.64% | video | 0.74% | cross modal | 0.71% | matching | 0.70% |

| diffusion | 0.64% | end to end | 0.74% | representation learning | 0.71% | weakly supervised | 0.70% |

| parsing | 0.64% | tracking | 0.65% | end to end | 0.71% | resolution | 0.70% |

| text to image | 0.53% | space | 0.65% | identification | 0.57% | transfer learning | 0.70% |

| video | 0.53% | weakly supervised | 0.65% | weakly supervised | 0.57% | style transfer | 0.56% |

| end to end | 0.53% | adaptation | 0.65% | search | 0.57% | tracking | 0.56% |

| verification | 0.53% | diffusion | 0.65% | resolution | 0.57% | decoder | 0.56% |

| detector | 0.53% | identification | 0.65% | adaptation | 0.57% | domain adaptation | 0.56% |

| contrastive learning | 0.53% | resolution | 0.56% | compression | 0.57% | self supervised | 0.56% |

| disentangl | 0.53% | distillation | 0.56% | expert | 0.57% | tuning | 0.56% |

| synthetic | 0.53% | vision and language | 0.56% | knowledge transfer | 0.57% | segmentation | 0.56% |

| representation learning | 0.53% | domain adaptation | 0.56% | multi modal | 0.57% | representation learning | 0.56% |

| latent | 0.53% | feature | 0.56% | correction | 0.57% | expert | 0.56% |

| classifier | 0.56% | feature | 0.57% | disentangl | 0.56% | ||

| grounding | 0.56% | space | 0.57% | answer | 0.56% | ||

| attack | 0.57% | weak supervision | 0.56% | ||||

| fusion | 0.56% | ||||||

| latent | 0.56% | ||||||

表4 論文出現キーワード推移(2021-2024年)

■まとめ

以上のように、自然言語処理分野について重要指標から考察してまいりました。

日本国内でも言語処理学会の盛況振りが伺えたり、各機関・コミュニティにおいてACL論文などの読み会や勉強会などが開催されると思われます。本記事が皆さまのお役に立てば幸いです。

データ解析・公開にあたっては細心の注意を払っておりますが、万が一、間違いなどございましたら遠慮なく弊社までご連絡ください。

編集:ResearchPort事業部

■Contact

本記事に関する質問や、ご意見・ご要望などがございましたらResearchPortまでお問い合わせください。

https://research-p.com/contactform/

-

2025年10月20日

「ICCV2025」ResearchPortトップカンファレンス定点観測 vol.19