本記事3行要約:

● 論文投稿数7,404件、採択件数2,174件!採択率29.4%!

● 日本人研究者を含む論文は2,174件中86本!

● ICLRでもDiffusion(拡散モデル)がキーワードトレンドでトップに!

2024年5月中旬に開催された[ICLR 2024]について簡潔にまとめました。

これまで機械学習最高峰の国際カンファレンスとして、NeurIPSやICMLを取り上げて動向調査をしてまいりました。これらに加えて、コンピュータサイエンス・機械学習系のトップカンファレンスで第3位*1に食い込む重要会議が今回取り上げるICLR(International Conference on Learning Representation)です。

*1 「ResearchPort カンファレンスランク 2023年版」参照

ICLR 2024 開催概要

▶ 開催期間: 7 – 11 May., 2024

▶ 開催都市: Vienna, Austria

▶ 公式HP: https://iclr.cc/

■ICLRとは

2013年に米国アリゾナ州スコッツデールで開催されて以来、毎年4・5月に開催されています。

7月開催のICMLや12月開催のNeurIPSと、投稿時期や開催時期などが別シーズンになるため、比較的参加しやすい時期に行われております。

詳細は後述いたしますが、論文投稿数も7,000件超えで、採択率も30%弱とかなりの高難易度カンファレンスであることが分かります。

“representation”という一部の方にとっては聞きなれない用語が含まれた会議です。representationとは、一昔前では特徴量と言われていた、入力情報から識別や予測に役立つ情報を残した、もしくは強調した情報のことです。これを人為的に設計する従来の設計パラダイム(feature engineering)から、自動設計するパラダイムへとシフトさせたものが深層学習(deep learning)であり、“Representation Learning”とは深層学習の真髄の一つであるとも言えます。

近年の生成AIは、下流タスク(downstream task)において、より多次元の出力からなる生成を実現するものですが、そのための重要な概念に近い情報を潜在空間(latent space)で形成(latent vector)するための方法論とも言えます。ただ、他カンファレンス同様に、カンファレンスは裾野の広いトピックを含むため、ICLRでも当初のスコープに限らず、様々な下流タスクを含めて、非常に質の高い研究成果が報告されています。

■ICLR 2024総括

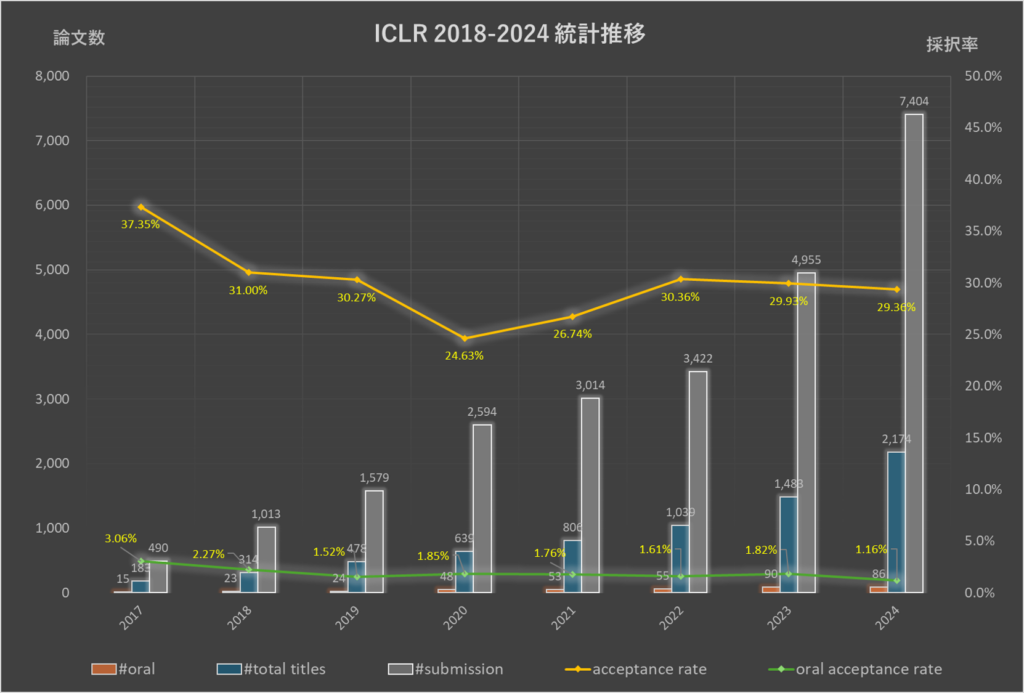

まず最初に投稿数・採択率の推移を見ていきます(表1・図1)。

本記事では、データがしっかり確認できた2018年以降を参照して考察してまいります。参考までに、2017年の投稿数・採択数/率も掲載しておきます。

2018年以降は、およそ30%前後の採択率で推移しており、特に口頭発表の採択率は2%を切るものとなっており、相当な難関であることが見て取れます。他AI関連カンファレンスと同様に、2022→2023→2024と年を追うごとに投稿件数は急増しており、直近の2024年回では7,000件を超える投稿数を記録いたしました。

| Year | #submissions | #spotlight | #poster | #total titles | acceptance rate | #oral | oral acceptance rate |

Venue |

|---|---|---|---|---|---|---|---|---|

| 2017 | 490 | 183 | 183 | 37.35% | 15 | 3.06% | Toulon, France | |

| 2018 | 1,013 | 0 | 314 | 314 | 31.00% | 23 | 2.27% | Vancouver, Canada |

| 2019 | 1,579 | 0 | 478 | 478 | 30.27% | 24 | 1.52% | New Orleans, USA |

| 2020 | 2,594 | 108 | 531 | 639 | 24.63% | 48 | 1.85% | Addis Ababa, Ethiopia |

| 2021 | 3,014 | 114 | 692 | 806 | 26.74% | 53 | 1.76% | Virtual |

| 2022 | 3,422 | 175 | 864 | 1,039 | 30.36% | 55 | 1.61% | Virtual |

| 2023 | 4,955 | 281 | 1,202 | 1,483 | 29.93% | 90 | 1.82% | Kigali, Rwanda |

| 2024 | 7,404 | 367 | 1,807 | 2,174 | 29.36% | 86 | 1.16% | Vienna, Austria |

表1 ICLR 2017-2024論文投稿数および採択率

注)表1内、「#spotlight」と「#poster」の合算値が「#total titles」となります。

■日本人研究者別-論文採択数

本カンファレンスでも、日本人著者の活躍も調べておりますので、下記に示します。(表2)

併せて、ICLR 2024個人別採択件数(図2)と、ICLR 2018-2024累積著者ランキング(図3)もご覧ください。(図2)

| 開催年 | 採択論文数 | 全著者数 | 平均著者数 | 日本人 著者数 |

日本人 著者比率 |

日本人著者 を含む論文 |

日本人著者が 絡む論文比率 |

|---|---|---|---|---|---|---|---|

| 2017 | 183 | ||||||

| 2018 | 314 | 1,418 | 4.52 | 15 | 1.06% | 7 | 2.23% |

| 2019 | 478 | 2,145 | 4.49 | 19 | 0.89% | 12 | 2.51% |

| 2020 | 639 | 3,045 | 4.77 | 25 | 0.82% | 17 | 2.66% |

| 2021 | 806 | 3,828 | 4.75 | 56 | 1.46% | 31 | 3.85% |

| 2022 | 1,039 | 5,096 | 4.90 | 61 | 1.20% | 39 | 3.75% |

| 2023 | 1,483 | 7,593 | 5.12 | 71 | 0.94% | 49 | 3.30% |

| 2024 | 2,174 | 11,927 | 5.49 | 131 | 1.10% | 86 | 3.96% |

表2 ICLR投稿論文全体の著者数に占める日本人比率の推移

全体の論文数の中で、日本人研究者が含まれている論文タイトルは2-3%後半ですが、徐々に増えている傾向が分かります。世界最前線で活躍される研究者が増えることは心強く勇気づけられます。

以下、図2では、ICLR 2024単年での日本人研究者個別採択件数を、図3では2018-2024年累積での採択件数をランキング形式でまとめております。累積件数は、非常に多数になるため、作図の関係上2件以上採択されていらっしゃる方のみに絞らせていただきました。

| 著者 | 採択数 |

|---|---|

| Tatsunori Hashimoto |

6

|

| Taiji Suzuki |

6

|

| Kenji Kawaguchi |

5

|

| Yuki Mitsufuji |

3

|

| Naoki Murata |

3

|

| Masashi Sugiyama |

3

|

| Toshimitsu Uesaka |

3

|

| Takuya Furusawa |

2

|

| Hiroki Furuta |

2

|

| Takeru Miyato |

2

|

| Atsushi Nitanda |

2

|

| Kazusato Oko |

2

|

| Hidenori Tanaka |

2

|

| Masayoshi Tomizuka |

2

|

| Masatoshi Uehara |

2

|

| Soji Adeshina |

1

|

| Akari Asai |

1

|

| Naoya Chiba |

1

|

| Daiki Chijiwa |

1

|

| Yasuhisa Fujii |

1

|

| Kenji Fukumizu |

1

|

| Hanan Gani |

1

|

| Kentaro Hara |

1

|

| Tatsuya Harada |

1

|

| Naoya Hasegawa |

1

|

| Yuka Hashimoto |

1

|

| Kohei Hayashi |

1

|

| Haruo Hosoya |

1

|

| Ryo Igarashi |

1

|

| Masaaki Imaizumi |

1

|

| Hirofumi Inaguma |

1

|

| Kentaro Inui |

1

|

| Kazuki Irie |

1

|

| Satoki Ishikawa |

1

|

| Isao Ishikawa |

1

|

| Takuya Ito |

1

|

| Tokio Kajitsuka |

1

|

| Sotaro Kaneda |

1

|

| Ryo Karakida |

1

|

| Kosuke Kawakami |

1

|

| Motoaki Kawanabe |

1

|

| Hiroshi Kera |

1

|

| Ren Kishimoto |

1

|

| Haruka Kiyohara |

1

|

| Goro Kobayashi |

1

|

| Ken Kobayashi |

1

|

| Seijin Kobayashi |

1

|

| Kazuhito Koishida |

1

|

| Taku Komura |

1

|

| Masanori Koyama |

1

|

| Soichiro Kumano |

1

|

| Tatsuki Kuribayashi |

1

|

| Takashi Maruyama |

1

|

| Tetsuro Morimura |

1

|

| Mitsuhiko Nakamoto |

1

|

| Kazuhide Nakata |

1

|

| Koichi Namekata |

1

|

| Yuto Nishimura |

1

|

| Kenta Niwa |

1

|

| Naoto Ohsaka |

1

|

| Tatsushi Oka |

1

|

| Kanta Ono |

1

|

| Yuta Saito |

1

|

| Kotaro Saito |

1

|

| Keisuke Sakaguchi |

1

|

| Yusuke Sekikawa |

1

|

| Takashi Shibuya |

1

|

| Atsushi Shimizu |

1

|

| Sho Sonoda |

1

|

| Keita Suzuki |

1

|

| Yuta Suzuki |

1

|

| Toyotaro Suzumura |

1

|

| Hideaki Takahashi |

1

|

| Sho Takemori |

1

|

| Toshihisa Tanaka |

1

|

| Tatsunori Taniai |

1

|

| Tadahiro Taniguchi |

1

|

| Keisuke Tateno |

1

|

| Riku Togashi |

1

|

| Ryota Tomioka |

1

|

| Ryo Ueda |

1

|

| Yuhei Umeda |

1

|

| Daisuke Urano |

1

|

| Yoshitaka Ushiku |

1

|

| Makoto Yamada |

1

|

| Kakei Yamamoto |

1

|

| Toshihiko Yamasaki |

1

|

| Shingo Yashima |

1

|

| Michihiro Yasunaga |

1

|

| Sho Yokoi |

1

|

| Takuma Yoneda |

1

|

図2 日本人研究者個人別 – ICLR 2024採択件数(91名)

日本人著者ランキング

| 著者 | 採択数 |

|---|---|

| Taiji Suzuki |

18

|

| Masashi Sugiyama |

15

|

| Tatsunori Hashimoto |

13

|

| Kenji Kawaguchi |

11

|

| Tatsuya Harada |

6

|

| Atsushi Nitanda |

6

|

| Hiroki Furuta |

5

|

| Masatoshi Uehara |

5

|

| Kenji Fukumizu |

4

|

| Masanori Koyama |

4

|

| Yuki Mitsufuji |

4

|

| Takeru Miyato |

4

|

| Hidenori Tanaka |

4

|

| Masahito Ueda |

4

|

| Akari Asai |

3

|

| Satoshi Hara |

3

|

| Kazuki Irie |

3

|

| Naoki Murata |

3

|

| Kazusato Oko |

3

|

| Masayoshi Tomizuka |

3

|

| Toshimitsu Uesaka |

3

|

| Yoshitaka Ushiku |

3

|

| Makoto Yamada |

3

|

| Michihiro Yasunaga |

3

|

| Soji Adeshina |

2

|

| Shunta Akiyama |

2

|

| Kenji Doya |

2

|

| Takuya Furusawa |

2

|

| Kazuma Hashimoto |

2

|

| Masaaki Imaizumi |

2

|

| Kentaro Inui |

2

|

| Yusuke Iwasawa |

2

|

| Ryuichi Kanoh |

2

|

| Ryo Karakida |

2

|

| Masahiro Kato |

2

|

| Hiroshi Kera |

2

|

| Seijin Kobayashi |

2

|

| Takashi Maruyama |

2

|

| Shiori Sagawa |

2

|

| Keisuke Sakaguchi |

2

|

| Fumihiro Sasaki |

2

|

| Yusuke Sekikawa |

2

|

| Mahito Sugiyama |

2

|

| Eiichiro Sumita |

2

|

| Ichiro Takeuchi |

2

|

| Ryota Tomioka |

2

|

| Ryo Ueda |

2

|

| Shingo Yashima |

2

|

| Sho Yokoi |

2

|

| Yuichi Yoshida |

2

|

図3 ICLR 2018-2024 累積著者ランキング(50名)※2件以上採択

■トレンドキーワードの推移

扱われているトピックの推移をみるために、キーワードトレンドについても集計してみました(表3)。

他AI関連分野カンファレンス同様に、Diffusion(拡散モデル)というキーワードが全体の14%強となっており、研究対象の大きな一角を占めていることが分かります。理論的な枠組みで議論展開がしやすいことから研究が進んでいるのかもしれません。

2位以降を見てみると、ICLRが始まってから昨年まで、大きな研究対象となってきたReinforcement Learning(強化学習)が5年ぶりに2位にランクダウンしております。次いで、Language Model(言語モデル)・Federated Learning(連合学習)・Generative(生成)・Spars(スパース学習)・Transformerと続いています。これらのキーワード後に、LLM(大規模言語モデル)も出現してきており、Language Modelと合算するとかなりの件数になります。

言語モデル自体の研究に加え、言語モデルを活用して学習データを整備したり評価に使ったり、様々な応用も提案されていることが分かります。

表3 論文出現キーワード推移(2018-2024年)

■まとめ

以上のように、簡易的ですが重要指標からICLRを考察してまいりました。

2023年から2024年で1.5倍増が、翌年も同水準で増加したとすると、ICRL 2025も10,000件超えが想定されます。NeurIPSやCVPRなど、投稿論文数が10,000件を超えるカンファレンスが増えてきてる流れが、このICLRにも迫ってきている状況が分かりました。

引き続き、AI関連分野の重要カンファレンスとしてICLRの盛況振りを調査してまいります。

データ解析・公開にあたっては細心の注意を払っておりますが、万が一、間違いなどございましたら遠慮なく弊社までご連絡ください。

編集:ResearchPort事業部

■Contact

本記事に関する質問や、ご意見・ご要望などがございましたらResearchPortまでお問い合わせください。

https://research-p.com/contactform/

-

2025年10月20日

「ICCV2025」ResearchPortトップカンファレンス定点観測 vol.19