本記事3行要約:

● 投稿数 11,239・採択数 2,702(採択率 24.04%)ともに最多更新

● 日本人著者は前年比約170%増で存在感拡大(68件/のべ149名)、国産CV研究の勢いが鮮明

● 生成(diffusion)+video/3D表現(Gaussian Splatting)が手法論の軸

トップカンファレンス定点観測シリーズ vol.19、「ICCV」です。

ResearchPortでは、これまでコンピュータビジョン分野のトップティアのカンファレンスとして、CVPRやECCVの盛況感について記事にしてまいりました。CV分野の最高峰会議であるECCVとICCVは隔年開催で、今年はICCV2025がハワイ ホノルルにて開催されました。

いよいよICCVでも投稿数が10,000件を超え、今年も多くの参加者が想定される注目カンファレンスです。現地参加される方や、関連研究をされている方々のお役に立てばと思い、開催に合わせて速報記事として統計情報をまとめております。

ICCV2025 開催概要

▶ 開催期間: Oct 19 – 23th, 2025

▶ 開催都市: Honolulu, Hawai’i

▶ 公式HP: https://iccv.thecvf.com/

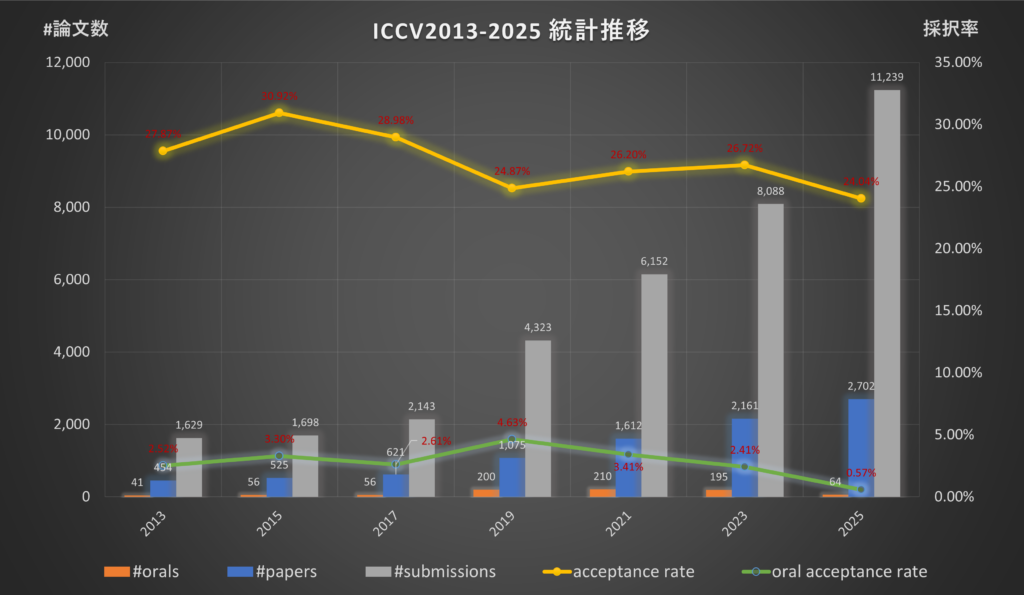

■ICCV2025総括

相変わらずコンピュータビジョン分野の盛り上がりはすごいもので、CVPR2025に続きICCV2025でも投稿数・論文採択数(poster)は過去最高を更新しております。

これまでの推移とともに、今年の成果を以下の[表1] / [図1]でご確認ください。

| Year | #papers | #orals | #submissions | acceptance rate | oral acceptance rate |

venue |

|---|---|---|---|---|---|---|

| 2013 | 454 | 41 | 1,629 | 27.87% | 2.52% | Sydney, Australia |

| 2015 | 525 | 56 | 1,698 | 30.92% | 3.30% | Santiago, Chille |

| 2017 | 621 | 56 | 2,143 | 28.98% | 2.61% | Venice, Italy |

| 2019 | 1,075 | 200 | 4,323 | 24.87% | 4.63% | Seoul, Korea |

| 2021 | 1,612 | 210 | 6,152 | 26.20% | 3.41% | Virtual |

| 2023 | 2,161 | 195 | 8,088 | 26.72% | 2.41% | Paris, France |

| 2025 | 2,702 | 64 | 11,239 | 24.04% | 0.57% | Hawaii, USA |

表1 ICCV論文投稿数および採択率

*出展: https://openaccess.thecvf.com/menu

今年は11,239件の論文が投稿され、2,702件のposter論文が採択されました。採択率は24.04%です。2013年から計測して最も採択率が低くなっております。oral発表論文は64件と昨年の1/3以下となりました。oral採択率は0.57%です。

oral採択数が大きく減ったことに関しては、おそらく会場の都合上、従来までのパラレルからシングルセッションになっため受入可能枠が大きく減少したことによるものと思われます。

■日本人研究者の活躍

ICCV2025でも、日本人著者の比率も調べておりますので、結果は以下参照ください。[表2・図2・図3]。こちらは昨年比約170%増と大きく躍進し、日本人研究者の皆さまの研鑽が垣間見られる結果となっています。

これは国内コンピュータビジョン研究の盛り上がりを感じられる数字ではないでしょうか。

| 開催年 | 採択 論文数 |

著者数 | 日本人著者 のべ人数 |

日本人 著者比率 |

日本人著者 を含む論文数 |

日本人著者が 絡む論文比率 |

|---|---|---|---|---|---|---|

| 2013 | 454 | 1,541 | 22 | 1.43% | 14 | 3.08% |

| 2015 | 525 | 1,997 | 46 | 2.30% | 20 | 3.81% |

| 2017 | 621 | 2,550 | 34 | 1.33% | 16 | 2.58% |

| 2019 | 1,075 | 4,837 | 60 | 1.24% | 25 | 2.33% |

| 2021 | 1,612 | 8,044 | 67 | 0.83% | 33 | 2.05% |

| 2023 | 2,161 | 11,562 | 87 | 0.75% | 45 | 2.08% |

| 2025 | 2,702 | 16,034 | 149 | 0.93% | 68 | 2.52% |

表2 ICCV投稿論文全体の著者数に占める日本人比率の推移

| 著者 | 採択数 |

|---|---|

| Nakamasa Inoue |

5

|

| Shunsuke Saito |

4

|

| Yuki Asano |

3

|

| Daisuke Iso |

3

|

| Shuhei Kurita |

3

|

| Yuta Nakashima |

3

|

| Masayoshi Tomizuka |

3

|

| Daichi Azuma |

2

|

| Takeo Igarashi |

2

|

| Hirokatsu Kataoka |

2

|

| Taku Komura |

2

|

| Kazuki Kozuka |

2

|

| Yasuyuki Matsushita |

2

|

| Yuki Mitsufuji |

2

|

| Taiki Miyanishi |

2

|

| Fumio Okura |

2

|

| Ryusuke Sagawa |

2

|

| Koya Sakamoto |

2

|

| Hiroaki Santo |

2

|

| Imari Sato |

2

|

| Yoichi Sato |

2

|

| Risa Shinoda |

2

|

| Takaaki Shiratori |

2

|

| Yoshitaka Ushiku |

2

|

| Naoto Yokoya |

2

|

| Jiro Abe |

1

|

| HIroyasu Akada |

1

|

| Yoshimitsu Aoki |

1

|

| Shusaku Egami |

1

|

| Kent Fujiwara |

1

|

| Ken Fukuda |

1

|

| Ryosuke Furuta |

1

|

| Kanoko Goto |

1

|

| Ryo Hachiuma |

1

|

| Kensho Hara |

1

|

| Atsushi Hashimoto |

1

|

| Akio Hayakawa |

1

|

| Toshiki Hazama |

1

|

| Takumi Hirose |

1

|

| Yusuke Hirota |

1

|

| Yuki Ikebe |

1

|

| Satoshi Ikehata |

1

|

| Koki Inoue |

1

|

| Naoto Inoue |

1

|

| Shu Ishida |

1

|

| Masato Ishii |

1

|

| Atsuya Ishikawa |

1

|

| Ryo Kamoi |

1

|

| Naoshi Kaneko |

1

|

| Asako Kanezaki |

1

|

| Yusuke Kato |

1

|

| Takayuki Kawabuchi |

1

|

| Yasutomo Kawanishi |

1

|

| Itaru Kitahara |

1

|

| Takumi Kobayashi |

1

|

| Norimasa Kobori |

1

|

| Akio Kodaira |

1

|

| Michihiro Kuroki |

1

|

| Takahiro Kushida |

1

|

| Yuta Kyuragi |

1

|

| Ryo Masumura |

1

|

| Ryota Mimura |

1

|

| Shogo Mitsuhori |

1

|

| Shotaro Miwa |

1

|

| Natsuki Miyata |

1

|

| Naoki Murata |

1

|

| Koki Nagano |

1

|

| Shunya Nagashima |

1

|

| Kazuma Nagata |

1

|

| Hiroki Nakamura |

1

|

| Gaku Nakano |

1

|

| Chihiro Nakatani |

1

|

| Ko Nishino |

1

|

| Kazumine Ogura |

1

|

| Kohei Ohno |

1

|

| Masaki Onishi |

1

|

| Shota Orihashi |

1

|

| Sakuya Ota |

1

|

| Kuniaki Saito |

1

|

| Jun Sakuma |

1

|

| Ikuro Sato |

1

|

| Shintaro Shiba |

1

|

| Takashi Shibuya |

1

|

| Kota Shimomura |

1

|

| Hikaru Shindo |

1

|

| Motoharu Sonogashira |

1

|

| Soichi Sugano |

1

|

| Komei Sugiura |

1

|

| Masashi Sugiyama |

1

|

| Yasuaki Susumu |

1

|

| Satoshi Suzuki |

1

|

| Tomoyuki Suzuki |

1

|

| Shusuke Takahashi |

1

|

| Takafumi Taketomi |

1

|

| Masato Taki |

1

|

| Hideki Tanaka |

1

|

| Kenichiro Tanaka |

1

|

| Manabu Tsukada |

1

|

| Mahiro Ukai |

1

|

| Norimichi Ukita |

1

|

| Yuki Urakawa |

1

|

| Masao Utiyama |

1

|

| Takuma Yagi |

1

|

| Kota Yamaguchi |

1

|

| Taiga Yamane |

1

|

| Toshihiko Yamasaki |

1

|

| Takayoshi Yamashita |

1

|

| Shunsuke Yasuki |

1

|

| Kaname Yokoyama |

1

|

| Ryo Yonetani |

1

|

| Takanori Yoshimoto |

1

|

| Masakazu Yoshimura |

1

|

| Kentaro Yoshioka |

1

|

| Yusuke Yoshiyasu |

1

|

図2 ICCV2025 日本人研究者個人別採択件数

累積採択数 日本人著者ランキング

| 著者 | 採択数 |

|---|---|

| Tatsuya Harada |

9

|

| Shunsuke Saito |

9

|

| Nakamasa Inoue |

8

|

| Imari Sato |

8

|

| Masayoshi Tomizuka |

8

|

| Yoichi Sato |

7

|

| Yasutaka Furukawa |

6

|

| Hirokatsu Kataoka |

6

|

| Taku Komura |

6

|

| Yasuyuki Matsushita |

6

|

| Kuniaki Saito |

6

|

| Yuta Nakashima |

5

|

| Ko Nishino |

5

|

| Shohei Nobuhara |

5

|

| Masatoshi Okutomi |

5

|

| Yoshitaka Ushiku |

5

|

| Kent Fujiwara |

4

|

| Daisuke Iso |

4

|

| Shuhei Kurita |

4

|

| Takayuki Okatani |

4

|

| Fumio Okura |

4

|

| Kota Yamaguchi |

4

|

| Kiyoharu Aizawa |

3

|

| Yuki Asano |

3

|

| Ryo Furukawa |

3

|

| Shinsaku Hiura |

3

|

| Hiroshi Kawasaki |

3

|

| Takumi Kobayashi |

3

|

| Koki Nagano |

3

|

| Ryusuke Sagawa |

3

|

| Risa Shinoda |

3

|

| Takaaki Shiratori |

3

|

| Masashi Sugiyama |

3

|

| Takafumi Taketomi |

3

|

| Norimichi Ukita |

3

|

| Masataka Yamaguchi |

3

|

| Toshihiko Yamasaki |

3

|

| Rio Yokota |

3

|

| Daichi Azuma |

2

|

| Kenji Hata |

2

|

| Takeo Igarashi |

2

|

| Satoshi Ikehata |

2

|

| Go Irie |

2

|

| Shun Iwase |

2

|

| Takeo Kanade |

2

|

| Sekitoshi Kanai |

2

|

| Kunio Kashino |

2

|

| Yasutomo Kawanishi |

2

|

| Kazuki Kozuka |

2

|

| Takahiro Kushida |

2

|

| Ryo Masumura |

2

|

| Yuki Mitsufuji |

2

|

| Taiki Miyanishi |

2

|

| Yusuke Mukuta |

2

|

| Hajime Nagahara |

2

|

| Hiroki Nakamura |

2

|

| Gaku Nakano |

2

|

| Kodai Nakashima |

2

|

| Chihiro Nakatani |

2

|

| Atsuhiro Noguchi |

2

|

| Satoshi Ono |

2

|

| Jun Saito |

2

|

| Koya Sakamoto |

2

|

| Hiroaki Santo |

2

|

| Ikuro Sato |

2

|

| Takami Sato |

2

|

| Shin’ichi Satoh |

2

|

| Yuki Shiba |

2

|

| Wataru Shimoda |

2

|

| Komei Sugiura |

2

|

| Satoshi Suzuki |

2

|

| Towaki Takikawa |

2

|

| Mikihiro Tanaka |

2

|

| Shin’ya Yamaguchi |

2

|

| Takayoshi Yamashita |

2

|

| Naoto Yokoya |

2

|

| Ryo Yonetani |

2

|

| Masakazu Yoshimura |

2

|

図3 ICCV2013-2025 累積採択数 日本人著者ランキング

■トレンドキーワードの推移

最後に、論文タイトルに含まれるキーワード出現比率も調べております[表3]。

ICCV2025でも、“image (14.62%)” “generation [generat***] (13.81%)” “video (12.03%)” “diffusion (11.73%)” が5位以下を大きく引き離し上位を独占しております。CVPR2025と同様に、生成系×画像・動画が大きなトレンドであると言えそうです。微増ではありますが、CVPRとの比較で、videoの出現頻度が上がっており、生成→動画編集/生成→評価という流れが加速した印象です。

“gaussian splat*** (3.48%)” “reconstruct (4.66%)” “represent (3.48%)” “scene/3d reconstruction (〜1%台)” “pose estimat*** (0.92%)” から、CVPRでも見えた 3次元復元の高速化の研究トレンドが顕著に現れています。生成/3D/動画のトレンドから見ると、それぞれを組み合わせたクロス領域(動画合成・再構築・表現学習など)も今後のトレンドになる可能性があるかもしれません。

* CVPR2025記事より、出現キーワードの抽出方法を大きく変更いたしました。

過去に公開したコラム内の出現キーワードとの順位相違や、新たなキーワードが追加されております。

*「***」がついている単語は、品詞の変化などを含めて解析しております。

例)generat*** ⇒ generative, generation, etc…

表3 論文出現キーワード推移(2025-2019年)

■まとめ

今回は、ICCV2025スタート直前に、予習的な意味合いで統計情報を公開させていただきました(2025年6月4日情報解析)。19日から始まるICCVに現地・オンラインで参加される方にとって、少しでも参考になれば嬉しい限りです。

● ResearchPortメンバーシップ募集:

https://research-p.com/?memberpage=registration

ResearchPortでは、研究者・技術者の方の研究事業開発サポートやキャリアサポートサービスを提供しております。研究・技術の事業化や、就職/転職をご検討の方などご要望があればResearchPortメンバーシップへご登録下さい。

編集:ResearchPort事業部

■Contact

本記事に関する質問や、ご意見・ご要望などがございましたらResearchPortまでお問い合わせください。

https://research-p.com/contactform/