本記事3行要約:

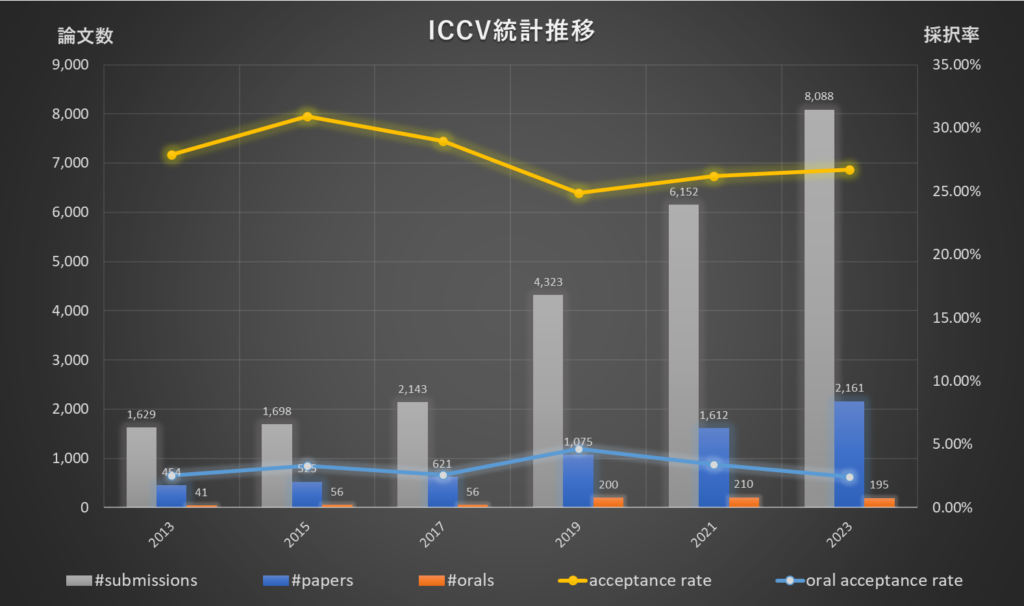

● ICCV2023で過去最多の投稿数「8,088件」・採択数「2,161件」を記録

● 日本人研究者の発表件数も過去最多の45件(のべ87名)

● CVPRに続き最多出現キーワードで[Diffusion model]がトップ

トップカンファレンス定点観測シリーズ vol.11、「ICCV」です。

ResearchPortでは、これまでコンピュータビジョン分野のトップティアのカンファレンスとして、CVPRやECCVの盛況感について記事にしてまいりました。

今回は、もう1つCV分野最高峰の会議であるICCVについて見てまいります。定点観測シリーズvol.7 (ECCV2022) でも述べた通り、ECCVとICCVは隔年開催で、今年2023年はICCVがパリにて開催されます。

以前より最多論文数がどんどん更新されており、日本からも多数の発表がされるICCVは10月2日 – 6日に開催されますので、現地参加される皆さまや関連研究をされている方々のお役に立てばと思い速報記事(2023年9月29日時点)として統計情報をまとめてみました。

ICCV 2023 開催概要

▶ 開催期間: 2-6 Oct., 2023

▶ 開催都市: Paris, France

▶ 公式HP: https://iccv2023.thecvf.com/

■ICCV2023総括

相変わらずコンピュータビジョン分野の盛り上がりはすごいもので、CVPR2023に続きICCV2023でも投稿数・論文採択数は過去最高を更新しております。

過去の数字とともに、今年の成果を以下の[表1] / [図1]でご確認ください。

| Year | #papers | #orals | #submissions | acceptance rate | oral acceptance rate |

venue |

|---|---|---|---|---|---|---|

| 2013 | 454 | 41 | 1,629 | 27.87% | 2.52% | Sydney, Australia |

| 2015 | 525 | 56 | 1,698 | 30.92% | 3.30% | Santiago, Chille |

| 2017 | 621 | 56 | 2,143 | 28.98% | 2.61% | Venice, Italy |

| 2019 | 1,075 | 200 | 4,323 | 24.87% | 4.63% | Seoul, Korea |

| 2021 | 1,612 | 210 | 6,152 | 26.20% | 3.41% | Virtual |

| 2023 | 2,161 | 195 | 8,088 | 26.72% | 2.41% | Paris, France |

表1 ICCV論文投稿数および採択率

*出展: https://openaccess.thecvf.com/menu

今年は8,088件の論文が投稿され、2,161件*1の論文が採択されました。採択率は26.72%です。この内、195件が口頭発表論文のため、oral採択率は2.41%です。これらの数値の伸びからも、コミュニティが引き続き成長していることがうかがえます。

*1 Program websiteでは2,160件と書かれていますが、prceedingsでは2,161件でしたので、こちらを採用しています。

■日本人研究者の活躍

ICCV2023でも、恒例となった日本人研究者がどれだけ活躍されているかというデータも調べてみました[表2]。日本人著者数も順調に増えてきております。

| 開催年 | 採択 論文数 |

著者数 | 日本人 著者数 |

日本人 著者比率 |

日本人著者 を含む論文 |

日本人著者が 絡む論文比率 |

|---|---|---|---|---|---|---|

| 2013 | 454 | 1,541 | 22 | 1.43% | 14 | 3.08% |

| 2015 | 525 | 1,997 | 46 | 2.30% | 20 | 3.81% |

| 2017 | 621 | 2,550 | 34 | 1.33% | 16 | 2.58% |

| 2019 | 1,075 | 4,837 | 60 | 1.24% | 25 | 2.33% |

| 2021 | 1,612 | 8,044 | 67 | 0.83% | 33 | 2.05% |

| 2023 | 2,161 | 11,562 | 87 | 0.75% | 45 | 2.08% |

表2 ICCV投稿論文全体の著者数に占める日本人比率の推移

| 著者 | 採択数 |

|---|---|

| Taku Komura |

4

|

| Masayoshi Tomizuka |

3

|

| Hirokatsu Kataoka |

3

|

| Shohei Nobuhara |

2

|

| Ko Nishino |

2

|

| Koki Nagano |

2

|

| Norimichi Ukita |

2

|

| Masashi Sugiyama |

2

|

| Rio Yokota |

2

|

| Nakamasa Inoue |

2

|

| Takami Sato |

2

|

| Shuhei Kurita |

1

|

| Naoki Katsura |

1

|

| Eri Onami |

1

|

| Takanori Asanomi |

1

|

| Daiki Suehiro |

1

|

| Ryoma Bise |

1

|

| Shu Nakamura |

1

|

| Yasutomo Kawanishi |

1

|

| Hideki Nakayama |

1

|

| Daichi Ito |

1

|

| Gaku Nakano |

1

|

| Shunsuke Saito |

1

|

| Hiroki Nakamura |

1

|

| Masashi Okada |

1

|

| Tadahiro Taniguchi |

1

|

| Towaki Takikawa |

1

|

| Kenji Hata |

1

|

| Hana Hoshino |

1

|

| Chihiro Nakatani |

1

|

| Hiroaki Kawashima |

1

|

| Masakazu Yoshimura |

1

|

| Junji Otsuka |

1

|

| Atsushi Irie |

1

|

| Takeshi Ohashi |

1

|

| Kaede Shiohara |

1

|

| Takafumi Taketomi |

1

|

| Ryuichiro Hataya |

1

|

| Hiromi Arai |

1

|

| Yuki Fujimura |

1

|

| Takahiro Kushida |

1

|

| Takuya Funatomi |

1

|

| Yasuhiro Mukaigawa |

1

|

| Mikihiro Tanaka |

1

|

| Kent Fujiwara |

1

|

| Ryo Ishii |

1

|

| Genki Osada |

1

|

| Tsubasa Takahashi |

1

|

| Yuriko Kobe |

1

|

| Ryo Nakamura |

1

|

| Sora Takashima |

1

|

| Tatsuya Harada |

1

|

| Kagaya Tomoyuki |

1

|

| Suzuki Tomoki |

1

|

| Masatoshi Okutomi |

1

|

| Takahiro Maeda |

1

|

| Takuhiro Kaneko |

1

|

| Satoshi Suzuki |

1

|

| Shin’ya Yamaguchi |

1

|

| Shoichiro Takeda |

1

|

| Sekitoshi Kanai |

1

|

| Naoki Makishima |

1

|

| Atsushi Ando |

1

|

| Ryo Masumura |

1

|

| Masahiro Hirano |

1

|

| Yuji Yamakawa |

1

|

| Risa Shinoda |

1

|

| Ryo Hayamizu |

1

|

| Kodai Nakashima |

1

|

| Shin’ichi Satoh |

1

|

| Michihiro Yasunaga |

1

|

| Shinya Wada |

1

|

図2 日本人研究者ごとのICCV2023採択件数 (72名)

■トレンドキーワードの推移

最後に、論文タイトルに含まれるキーワード出現比率も調べております[表3]。

CVPRに引き続き“Diffusion”がTransformerを抜いており、変わらず生成AIを支える技術として研究が進んでいることが分かります。

なお、3Dが2位に入っており、DNN時代における応用先として注目されていることも感じとることができます。

| 2019 | 2021 | 2023 | |||

|---|---|---|---|---|---|

| Object Detection | 6.23% | Domain Adaptation | 5.09% | Diffusion | 11.62% |

| Adversarial | 5.86% | 3D | 4.72% | 3D | 5.78% |

| Attention | 5.40% | Semantic Segmentation | 4.47% | Transformer | 5.23% |

| 3D | 4.56% | Object Detection | 4.47% | Object Detection | 4.12% |

| Unsupervised | 4.09% | Unsupervised | 4.28% | Domain Adaptation | 3.24% |

| Video | 3.81% | Adversarial | 4.28% | Unsupervised | 3.15% |

| Semantic Segmentation | 3.72% | Self Supervis | 4.09% | Semantic Segmentation | 2.73% |

| Domain Adaptation | 3.54% | Representation Learning | 3.97% | Attention | 2.73% |

| Re Identification | 3.26% | Transformer | 3.72% | Video | 2.73% |

| Weakly Supervised | 2.23% | Attention | 3.72% | Adversarial | 2.22% |

| Representation Learning | 2.23% | Video | 3.54% | Point Cloud | 2.22% |

| Few Shot | 1.77% | Contrastive Learning | 2.85% | Representation Learning | 2.22% |

| Point Cloud | 1.67% | Few Shot | 2.79% | Continual Learning | 2.13% |

| Person Re Identification | 1.58% | Point Cloud | 2.61% | Federated Learning | 2.04% |

| Metric Learning | 1.49% | Weakly Supervised | 2.36% | Self Supervis | 1.81% |

| End to End | 1.40% | Re Identification | 1.61% | Pre Training | 1.76% |

| Semi Supervised | 1.40% | Semi Supervised | 1.61% | Contrastive Learning | 1.67% |

| Zero Shot | 1.40% | Disentangl | 1.43% | Sparse | 1.62% |

| Captioning | 1.40% | Super Resolution | 1.37% | Pre training | 1.39% |

| Neural Network | 1.30% | End to End | 1.30% | Action Recognition | 1.25% |

| Self Supervis | 1.30% | Metric Learning | 1.24% | Knowledge Distillation | 1.25% |

| Shot Learning | 1.30% | Cross Modal | 1.12% | Semi Supervised | 1.16% |

| Action Recognition | 1.30% | Action Recognition | 1.06% | Super Resolution | 1.16% |

| Disentangl | 1.30% | Supervised Learning | 1.06% | Zero Shot | 1.11% |

| Style Transfer | 1.30% | Shot Learning | 1.06% | Few Shot | 1.06% |

| Super Resolution | 1.21% | Instance Segmentation | 1.06% | Image Generation | 1.06% |

| Attention Network | 1.12% | Continual Learning | 0.99% | Diffusion Model | 1.02% |

| Wild | 1.02% | Knowledge Distillation | 0.99% | Self supervis | 1.02% |

| Camera | 0.93% | Sparse | 0.99% | Instance Segmentation | 1.02% |

| Depth | 0.93% | Pre Training | 0.99% | Weakly Supervised | 1.02% |

| Sparse | 0.84% | Zero Shot | 0.93% | Reinforcement Learning | 1.02% |

| Instance Segmentation | 0.74% | Active Learning | 0.87% | Cross Modal | 0.88% |

| Face Recognition | 0.74% | Scene Graph | 0.74% | Multi Modal | 0.88% |

| Image Retrieval | 0.74% | Question Answer | 0.74% | Object Tracking | 0.88% |

| Adversarial Network | 0.74% | Wild | 0.74% | Domain Generalization | 0.83% |

| Reinforcement Learning | 0.74% | Style Transfer | 0.74% | Supervised Learning | 0.83% |

| Deep Learning | 0.65% | Image Retrieval | 0.68% | Incremental Learning | 0.83% |

| Knowledge Distillation | 0.65% | Image Generation | 0.68% | Boosting | 0.83% |

| Supervised Learning | 0.65% | Multi Modal | 0.62% | Text to Image | 0.74% |

| Image Captioning | 0.65% | Incremental Learning | 0.62% | Disentangl | 0.74% |

| Object Tracking | 0.65% | Object Tracking | 0.56% | Few shot | 0.74% |

| Unsupervised Learning | 0.56% | 3D Object Detection | 0.56% | Active Learning | 0.74% |

| Video Object Detection | 0.56% | Image Classification | 0.56% | Semi supervised | 0.65% |

| Spatio Temporal | 0.56% | Face Recognition | 0.56% | Style Transfer | 0.65% |

| 3D Reconstruction | 0.56% | Face Recognition | 0.60% | ||

| Image Classification | 0.56% | Image Classification | 0.60% | ||

| Cross Modal | 0.56% | End to End | 0.51% | ||

| Active Learning | 0.56% | supervised Learning | 0.51% | ||

| Captioning | 0.51% | ||||

| 3D Reconstruction | 0.51% | ||||

表3 論文出現キーワード推移(2019-2023年)

■まとめ

今回は、ICCV2023スタート前に、統計情報のみを簡潔にまとめ公開させていただきました。後日、載せきれなかった詳細情報など追加更新を予定しております。まずは来週より始まるICCV2023に参加される皆さまの参考になれば嬉しい限りです。

● ResearchPortメンバーシップ募集:

https://research-p.com/?memberpage=registration

ResearchPortでは、研究者・技術者の方の研究事業開発サポートやキャリアサポートサービスを提供しております。研究・技術の事業化や、就職/転職をご検討の方などご要望があればResearchPortメンバーシップへご登録下さい。

編集:ResearchPort事業部

■Contact

本記事に関する質問や、ご意見・ご要望などがございましたらResearchPortまでお問い合わせください。

https://research-p.com/contactform/

-

2025年10月20日

「ICCV2025」ResearchPortトップカンファレンス定点観測 vol.19